Sommaire

Introduction

Tout devient « Donnée »[1] et les sociétés de gestion d’actifs n’échapperont pas à la numérisation croissante de leurs activités. Ce constat fait consensus au sein des membres de l’AFG : l’étude conduite auprès d’eux montre que 100% des sondés estiment que la digitalisation est un enjeu fort pour l’industrie de la gestion d’actifs. Le phénomène de digitalisation est aujourd’hui accentué par l’effet conjugué de l’environnement macro-économique, de la crise sanitaire et de la menace climatique. L’industrie de la gestion d’actifs est alors confrontée à plusieurs enjeux :

- La volonté des investisseurs de gérer leur patrimoine à tout instant, partout et via tous types de supports technologiques. Ce phénomène dit « atawad» pour « Any time, any where, any device » est également évoqué dans la fiche : Innovations technologiques au service de l’expérience client.

- L’opportunité sans précédent pour l’industrie de la gestion d’actifs de guider l’effort massif d’investissement vers les entreprises respectant les critères ESG :

- Favorisant ainsi la création de nouveaux services ou produits s’appuyant sur une meilleure exploitation des données internes et externes (Voir la fiche : Stratégies organisationnelles et innovations technologiques) ;

- Mais exigeant également qu’elles montrent l’exemple « de bonne citoyenneté », notamment en maîtrisant leur empreinte environnementale. Cela se traduit par la production de reportings montrant le respect des objectifs de développement durable.

Le marché des capitaux européen étant le plus mature en matière d’ESG[2], ses acteurs disposent d’un avantage concurrentiel réel. Dans ce contexte, ces derniers ont une opportunité historique d’étendre leur savoir-faire en matière de produits et de solutions ESG[3], compte tenu de :

- La multiplication des reportings liés aux exigences réglementaires (à titre d’exemple : reporting SFDR, DAC 6, profil Client MIF…)

- La démocratisation des outils, méthodes ou techniques de data science, jusque-là peu accessibles à l’ensemble des sociétés de gestion (notamment celles de petite taille)

- L’intégration d’un mode de travail hybride des collaborateurs, en partie à distance et en partie sur site, « agilisant » les capacités de traitement de l’organisation (Voir la fiche : Adaptation du capital humain et gestion du changement). Mais l’augmentation de la surface d’exposition des données aura également pour conséquence une modification du risque de cybersécurité (Voir la fiche : Protéger ses systèmes contre les cyber-attaques).

Toutes ces tendances s’appuient sur l’exploitation de données collectées ou achetées.

De plus, la concrétisation dans le temps de ces tendances dépendra également de l’existant en matière d’infrastructures IT. Ainsi, selon l’étude AFG, plus de 75% des sondés mentionnent « l’existant en termes d’infrastructures IT », « le coût lié au déploiement des innovations digitales » ainsi que « l’incertitude quant à la réussite de la transformation digitale » comme les principaux freins à la digitalisation de l’industrie de la gestion d’actifs et par conséquent à une bonne exploitation des données.

Les enjeux pour l’industrie ne s’arrêtent pas au déploiement de l’IA. L’exploitation de la technologie de la blockchain et du calcul quantique sont les prochaines vagues technologiques qui s’alimenteront également de données. (Voir la fiche : Introduction aux crypto-actifs, à la blockchain (DLT) et à la finance décentralisée (DEFI)).

Pour de nombreux acteurs de l’industrie, la question de l’architecture data et des infrastructures IT pour relever ces défis se pose avec acuité. Des écosystèmes connectant différents acteurs et partenaires de la chaine de valeur du cycle d’investissement voient le jour à la faveur des possibilités offertes par les API et le Cloud.

Ici, comme dans les autres industries, la souveraineté des données et la souveraineté technologique sont devenues des enjeux à l’échelle européenne. À cet égard, la Commission européenne va accélérer la « dataification » des industries (services financiers y compris) au travers du « Data Governance Act » (2021) et du « Data Act » (2022), en créant de facto un espace européen de la Donnée favorisant l’accès, la circulation et l’échange des données sur des infrastructures et technologies sécurisées.

Quels sont les enjeux ?

L’ensemble des SGP a pris conscience que l’élaboration d’une stratégie claire d’exploitation des données représente des gains et un avantage concurrentiel réel. En effet, il est central d’avoir des jeux de données de qualité, judicieusement enrichies et interprétées. Cette valorisation s’accroît à mesure de l’interconnexion existante entre acteurs d’un écosystème. Désormais, comme dans d’autres secteurs, la donnée sert de « combustible au cœur du réacteur d’une SGP ». Une donnée correctement gouvernée et exploitée favorise la génération de revenus additionnels, la réalisation d’économies de coûts et l’amélioration de la qualité du service et des analyses produites.

Générer des revenus additionnels

L’augmentation du chiffre d’affaires induite par une exploitation optimale des données peut se produire tant grâce à une amélioration des services proposés qu’à l’aide d’une meilleure utilisation des canaux de distribution. L’émergence de nouveaux acteurs de la data permet désormais à une entreprise qui produit des données de mieux les valoriser afin de les commercialiser.

L’exploitation optimale de la donnée permet d’améliorer les produits et les services proposés et de créer de nouvelles solutions pour les clients. Grâce à l’utilisation d’algorithmes et à l’accroissement de la surface de données exploitables au moyen de données extra-financières, les SGP ont ainsi la capacité d’innover. A titre d’exemple, la Fintech française SESAMm utilise l’approche Big Data et sa capacité à traiter les données textuelles pour détecter les sentiments et émotions qui affectent les marchés financiers. Avec sa maîtrise du Machine Learning, la start-up Kavout[4] teste des stratégies d’investissement par le biais d’un algorithme prédictif qui produit une notation et classe les valeurs selon leur potentiel de croissance.

En couplant l’utilisation d’algorithmes reposant sur l’Intelligence Artificielle au « data management », les SGP peuvent espérer augmenter l’efficience des processus de commercialisation et marketing. McKinsey identifie deux avantages majeurs : d’une part, une hausse des revenus des asset managers de 5% à 30% sur le segment « vente et marketing » de la chaine de valeur (segmentation comportementale des clients, prospection et rétention des clients, marketing personnalisé…), et d’autre part une précision supérieure à 80% dans l’identification d’opportunités de ventes couplée à des résultats de vente jusqu’à dix fois supérieurs par rapport à des sociétés de gestion qui n’ont pas utilisé ces outils d’analyse.

Monétiser les données à l’extérieur des SGP est désormais possible grâce à leur structuration et à une meilleure valorisation. En partant du constat que la donnée est un actif, la start-up Dawex a créé un système de marché d’échange des données.

Réaliser des économies de coûts

Automatiser les tâches répétitives, augmenter l’efficience des processus opérationnels, améliorer la gestion des risques et la conformité, réduire le temps dédié à l’analyse sont autant d’avantages liés à une meilleure exploitation des données par les SGP.

L’automatisation des tâches répétitives et standardisées peut être menée à bien par l’utilisation de RPA (Robotic Process Automation). Cet outil a l’avantage d’être transposable à des activités différentes : revue des transactions et règlement/livraison, reporting et analyses simples, clôture comptable, par exemple. Selon une étude[5], 52% des gestionnaires d’actifs interrogés utilisent le RPA dans leurs opérations et 82% d’entre eux assurent que les résultats sont concluants.

L’efficience augmentée des processus opérationnels :

- L’utilisation d’algorithmes IA couplée au « data management », permettrait également de réduire les coûts[6] de middle et back-office de 10 à 30 % (automatisation des processus, et de la surveillance des négociations…). Citons par exemple, la société NEPHELAI (https://www.nephel-ai.com) dont la solution permet de détecter et réduire les erreurs de transactions.

- Mesurer la qualité des données[7] est un défi et les « data scientists » passent plus de 80% de leur temps à préparer et à nettoyer les données pour les rendre utilisables. Des logiciels tels que Talend proposent d’aider à améliorer la qualité des données.

- Une donnée correctement gouvernée et organisée diminue la dette technique (la qualité des données contribue à améliorer la dette technique et ainsi à réduire les coûts) ainsi que le temps collaborateurs mobilisé à des tâches sans valeur ajoutée métier.

- Une meilleure gestion des coûts d’acquisition des données auprès de data providers (par exemple anticiper les modalités de paiement à l’usage, par abonnement, avec effet de seuil, avec économie d’échelle…)

Améliorer la qualité du service et des analyses produites

La technique NLP (Natural Language Programming) peut extraire plus de 4 millions de données et réduit de 60% le temps requis pour générer des rapports efficaces[8]. Ainsi, les gestionnaires d’actifs qui ont mis en œuvre des algorithmes et l’IA ont constaté une réduction de 55 à 85 % du temps consacré aux activités de surveillance commerciale et une meilleure identification des risques. Par exemple, NN Investment Partners[9] intègre des données de sentiments de marché fournies par MarketPsych pour anticiper les secteurs et entreprises bénéficiant de sentiments positifs et éventuellement ajuster leurs décisions d’investissements et le narratif associé.

Quels sont les défis ?

Les défis concernent principalement l’obsolescence des infrastructures existantes et le manque d’outillage adapté pour exploiter les données internes et externes (informations extra-financières, réseaux sociaux…).

L’enquête réalisée par l’AFG auprès de ses membres montre que les principaux défis concernant la donnée sont par ordre de priorité : la sécurité des données, la présentation des données (reporting), la qualité des données ainsi que l’analyse des données.

Néanmoins, bon nombre d’études conduites ces 3 dernières années sur un panel d’entreprises toutes industries confondues cherchant à identifier les principales barrières à l’adoption de l’IA dans les organisations, relèvent les freins[10] suivants :

- Le manque de compétences dans les domaines de la science de données ou de la gestion de la donnée

- La difficulté à identifier les « use cases » et les bénéfices associés à leurs mises en œuvre

- L’inadéquation des plateformes ou des outils pour exploiter les données.

Mettant en exergue le poids et l’inertie à la transformation du SI legacy existant…

Au-delà du sujet de l’accès à la donnée, les sociétés de gestion doivent également surmonter des obstacles pour extraire des informations utiles des données brutes, notamment :

- La complexité de la donnée et l’obsolescence des plateformes de gestion de la donnée

- L’outillage nécessaire pour l’analyse et le traitement des données non-structurées

- La complexité des outils analytiques

Enfin, côté gérants, dans les structures les plus avancées, l’océan de données à analyser a vu l’émergence de modèles algorithmiques multiples et variés produisant des résultats difficiles à expliquer et à exploiter.

…mais aussi le coût des données externes à collecter

Outre la question de la nature des données manipulées et des moyens à mettre en œuvre pour les exploiter au mieux, les sociétés de gestion sont confrontées :

- Au coût d’acquisition des données provenant de fournisseurs traditionnels de données externes

- Au coût d’acquisition de nouvelles données externes, notamment extra-financières pour alimenter de nouveaux besoins, qu’ils soient réglementaires (par exemple reporting ) ou business (acquisition de données alternatives pour améliorer le processus d’investissement).

Quelle est la typologie des données ?

La donnée de qualité devient un intrant crucial pour de nombreux processus de la chaïne de valeur. Comme le montre le tableau ci-dessous, une société de gestion est irriguée de données qu’elle produit ou qui proviennent de tiers. La quasi-totalité des données utilisées aujourd’hui sont structurées.

Le tableau indique notamment l’origine des données manipulées (interne ou externe à la société de gestion) et les consommateurs de ces données.

Tableau : liste des familles de données d’une SGP

| Outils | Famille de données | Description | Catégories | Source | Consommateurs |

|---|---|---|---|---|---|

| Référentiels | Valeurs | Caractéristiques des titres et contrats négociables | Structurées | Interne | Back Office Middle Office |

| Données fournies par Bloomberg, Markit, DataStream, Thomson Reuters… | Structurées | Externe | Gérants | ||

| Benchmarks | Caractéristiques des indices et benchmarks | Structurées | Interne | Marketing | |

| Données provenant des fournisseurs de données type MSCI, Ester | Structurées | Externe | |||

| Tiers | Caractéristiques des tiers avec qui la société de gestion est en relation (brokers, dépositaires, contreparties de négociation, fournisseurs de données…) | Structurées | Externe | ||

| Fonds | Caractéristique des fonds de la société de gestion d’actifs | Structurées | Interne | ||

| Commercialisation & Marketing | Offre produits | Données liées à la gestion de la gamme produit | Structurées | Interne | Marketing |

| Données liées aux clients | Structurées | Interne | Marketing | ||

| Informations additionnelles servant à créer ou à ajuster l’offre et à l’identification de nouveaux profils client | Structurées / non structurées | Externe | Marketing | ||

| Front-Office (OMS) | Recherche | Données micro-et macro-économiques nécessaires à la prise de décision d’investissement (sociétés, secteurs d’activités…), sélection d’actifs et allocation | Structurées / non structurées | Interne & Externe | Marketing |

| Front Office | |||||

| Investissement | Clients | ||||

| Gestion des ordres | Données sur le passage d’ordres du gérant vers la table de négociation | Structurées | Interne | Back Office | |

| Données pré-trade liées aux contraintes réglementaires ou internes (ex : limites) | Structurées | Interne | Brokers | ||

| Middle Office | Règlement – livraison | Données liées au règlement – livraison des opérations | Structurées | Interne | Dépositaires |

| (PMS) | Suivi des positions | Données liées à la tenue des positions (incluant OST, trésorerie prévisionnelle…) | Structurées | Interne | |

| Réconciliation | Données utilisées pour effectuer le rapprochement des opérations et des positions (entre MO et dépositaires) | Structurées | Interne | ||

| Performance | Données issues des référentiels produits | Structurées | Interne | ||

| Données provenant des fournisseurs de données type MSCI, Ester, | Structurées | Externe | |||

| Back Office | Valorisation | Données utilisées pour réaliser le calcul des valeurs liquidatives | Structurées | Interne | Middle Office Marketing Clients |

| Comptabilisation | Structurées | Interne | Finance | ||

| Risques & conformité | Contrôles | Données utilisées pour exécuter les contrôles opérationnels | Structurées | Interne | Conformité Risques |

| Métriques risques | Données utilisées pour calculer les indicateurs de risques marché (volatilité…) | Structurées | Externe | Risques | |

| Reporting | Financier | Données de pilotage | Structurées | Interne | Management Régulateur |

| Extra-financier | Données couvrant les besoins de reportings ESG principalement | Structurées | Externe | Clients |

FOCUS sur une typologie de données externes : les données alternatives

« Avec les avancées récentes dans l’analyse de données, nous avons désormais accès à des bases de données larges et complexes provenant, par exemple, des volumes de consommation ou d’investissement des particuliers, du trafic sur le web, des médias, des réseaux sociaux ou encore de l’imagerie satellite etc… Toutes ces données apportent des informations précieuses sur les comportements économiques des individus ou des entreprises, et ont de nombreuses applications pour les investisseurs. Les sociétés de gestion d’actifs et les hedge funds ont déjà considérablement investi dans les données alternatives. Et cette tendance est vouée à croître, en raison des besoins grandissants, notamment sur les données ESG. Les données alternatives offrent de nouvelles perspectives, mais elles ont aussi des limites comme le manque de profondeur historique ou des biais de sélection », a contextualisé, en introduction du webinaire, Marie Brière, directrice scientifique du programme FaIR (cf. les données alternatives sont utiles pour la gestion d’actifs, site Institut Louis Bachelier – webinar organisé par le programme de recherche Finance and Insurance Relodaed (FaIR) de l’Institut Louis Bachelier (ILB) et l’Association Française de Gestion (AFG), le 10 février 2022).

Les usages sont multiples, il est ainsi possible de détecter des thématiques émergentes ou récits (narratives en anglais) et d’analyser leur importance pour les marchés financiers. Ronnie Sadka, professeur de finance au Boston College, a classé ces « récits » en trois catégories : ceux qui concernent l’évaluation des actifs, par exemple boursiers en observant notamment les réseaux sociaux ; les récits liés à des variables macroéconomiques (PIB, inflation, taux de chômage…) dont les publications ne sont pas quotidiennes et qui nécessitent des prévisions entre chaque annonce ; les récits concernant des éléments intangibles difficiles à mesurer comme les événements géopolitiques : Brexit, guerres commerciales, crise de la Covid-19, pénuries…

Ainsi, selon Ronnie Sadka, « les données alternatives peuvent être très utiles si elles sont utilisées correctement. L’un des cas d’usage est qu’avec les médias, on peut quantifier l’importance de certains récits dans la presse et leur impact sur les marchés, et ainsi mieux comprendre ce qui suscite l’attention des investisseurs ».

L’essor de la Data Science rend désormais possible leur exploitation par le plus grand nombre, même si introduire des données alternatives à un modèle financier n’est pas chose aisée et n’est pas à la portée de toutes les sociétés. Outre les compétences, l’équipement physique et le consentement des utilisateurs pour certaines données (RGPD), l’acquisition des jeux et base de données se chiffrent en centaines de milliers d’euros, voire en millions d’euros et une taille critique est nécessaire pour rentabiliser l’investissement.[11] Des sociétés comme QuantCube Technology permettent de générer des signaux d’investissement à partir de données alternatives.

Que faire ?

A l’instar du pétrole, la donnée doit être :

- Extraite ou collectée

- Conduite sur le ou les lieux d’exploitation ou de transformation

- Contrôlée, notamment en termes de qualité

- Transformée, en particulier en produisant des nouvelles données ou des données agrégées

- Acheminée sur les lieux d’utilisation ou de restitution finale

A la différence du pétrole, la donnée est réutilisable à l’envie et est infinie.

Pour ce faire, une gouvernance de données est a minima nécessaire, définie et pilotée par un Data Office. Cette gouvernance s’appuie sur 5 caractéristiques principales des données :

- Intégrité et traçabilité des données : caractéristique d’une donnée à n’être modifiée que par des personnes autorisées et selon un protocole défini, historisant les différentes modifications subies par la donnée

- Accessibilité et disponibilité des données : caractéristique d’une donnée à être utilisable par l’utilisateur autorisé, selon des canaux définis, à l’heure et à l’endroit prévus

- Sécurité et confidentialité des données : caractéristique d’une donnée à n’être accessible et utilisée que par les personnes autorisées et selon les usages autorisés

- Fiabilité des données : caractéristique d’une donnée de qualité, reflétant l’exactitude de l’information à restituer

- Valorisation et usages des données : caractéristique d’une donnée pleinement exploitée au travers de différents usages

Une bonne pratique est d’en confier la définition et la mise en œuvre à un data office piloté par un Chief Data Officer (Voir la fiche : Adaptation du capital humain et gestion du changement). Outre le pilotage de la gouvernance des données, le CDO a pour principales missions de :

- Co-définir et piloter la stratégie data

- Établir la cartographie des données critiques, servant pour des usages critiques

- Définir les rôles et responsabilités et processus de production et de contrôle des données

- Établir et suivre les niveaux de qualité attendus par périmètre de données

- Co-concevoir l’architecture de collecte, de stockage, d’exploitation et de restitution des données

- Valoriser le patrimoine des données en lien avec les autres métiers de la société de gestion

- Acquérir des données externes (données alternatives pouvant servir à une meilleure connaissance des sociétés analysées pour extraire des signaux d’investissements…)

Le Data Office est le lieu privilégié où les questions suivantes sont traitées :

- Quelles données partager ? Quelles données mutualiser ?

- Quelles données sont suffisamment gouvernées pour être exploitables ?

- Quels sont les coûts des données externes ? Comment en optimiser l’achat et l’utilisation (éviter les redondances, les licences abusives par exemple) ?

QUALITÉ DES DONNÉES

Le Data Office anime par ailleurs la comitologie data servant à assurer qu’une donnée de qualité circule bien à la fois à l’intérieur des chaînes de valeur de la société, mais aussi à destination des partenaires ou acteurs externes.

Soulignons à cet égard, que les plateformes ou solutions proposées par des acteurs comme Amundi (Alto), Natixis Investment Managers (Asset Studio) ou BlackRock (Aladdin) ne peuvent fonctionner et répondre aux attentes des utilisateurs que si les données ingérées sont fiables.

Selon la taille des sociétés de gestion et de leurs effectifs, l’organisation peut varier énormément :

| Taille de la structure | Equipe en charge de la Data |

|---|---|

| Petites structures | RCCI, Risque, administrateur base de données ou dirigeant |

| Structures intermédiaires | Département IT |

| Structures de grande taille | Data Office |

Comment adapter son organisation ?

Architectures et dispositifs

Face à l’émergence de données protéiformes, se pose la question des architectures à adopter pour optimiser l’exploitation du patrimoine de données et en contenir les coûts d’opération, notamment en termes de cohérence et de qualité. Pour faire face à ces problématiques, les grandes sociétés de gestion ont opté pour une centralisation de leurs référentiels, induisant la constitution d’équipes de contrôles, de nettoyage et d’enrichissement des données.

Ainsi pour la production de rapports, l’ensemble des acteurs doit disposer des mêmes données (prix, taux des devises, références des valeurs…) du front et middle office de la société de gestion jusqu’au back office des dépositaires et valorisateurs de portefeuilles.

Les grands acteurs se sont structurés autour de dispositifs tels que :

- La gestion des référentiels : intégration et contrôles des caractéristiques clés des titres et portefeuilles

- La valorisation des actifs

- La production de KPI et KRI de suivi et de monitoring

L’existence de ce type de dispositif représente aujourd’hui un avantage compétitif car il n’est pas rare qu’avant d’activer un mandat, des audits soient dépêchés sur place pour s’assurer que la société de gestion soit correctement outillée pour produire des rapports et analyses de qualité.

Écosystème : infrastructure, hors du cloud point de salut ?

Les sociétés de gestion choisissent désormais le cloud comme socle de leur infrastructure. A court terme, celles qui n’ont pas encore effectué la migration de leur SI vers le cloud (public, privé ou hybride selon le choix fait par la société) doivent réfléchir à cette opportunité. Les bénéfices de cette transition sont[12] :

- Répondre aux nouveaux enjeux métiers

- Gagner en agilité, réactivité, flexibilité et time to market, déploiement à l’échelle

- Harmoniser et centraliser des systèmes permettant des économies d’échelle

- Réduire la dette technique[13]

- Rationaliser ses datacenters et ses infrastructures

- S’adapter à une variabilité du business (pics et creux d’activité)…

Le cloud permet ainsi une plus grande centralisation des données, une meilleure rentabilité, une évolutivité augmentée ainsi qu’une accessibilité améliorée. Cela se traduit in fine par une réduction des coûts opérationnels globaux.

Il n’existe pas de modèle de migration standard. Le choix du cloud est une décision qui impacte la gouvernance, l’architecture, l’organisation, et demande de la préparation et de l’adaptation. C’est pourquoi une stratégie doit être établie, notamment s’agissant des SI à « cloudifier ». Il existe de nombreuses manières de migrer[14] selon les enjeux stratégiques, les compétences internes, l’état du parc applicatif, les exigences environnementales… Finalement, il est certain que la démarche a des effets collatéraux positifs tels que :

- L’élaboration de la cartographie du parc applicatif

- Le traitement de la dette technique du SI

- La sécurisation du SI

La migration dans le cloud signifie également réorganisation et mutation des équipes IT. Le modèle initial axé sur la gestion des stocks (datacenters) devient un modèle de gestion de flux. De nouveaux métiers émergent, à l’instar des DevOps[15], FinOps[16] et autres architectes cloud, induisant de nouvelles manières de travailler. L’insertion de cette technologie s’accompagne d’une démarche « test & learn ».

Enfin, le choix du fournisseur cloud est stratégique, car l’impact sur l’architecture SI est structurante. Il convient donc de bien connaître les avantages et points d’amélioration du partenaire sélectionné pour faire un choix éclairé.

Écosystème : partage des données

L’insertion de la technologie cloud facilite le partage des données entre acteurs, mais elle n’est pas sans soulever des problématiques de disponibilité (réseau, temps réel, historique) et de sécurité.

La plate-forme MANAOS, filiale de BPSS, place de marché ouverte (« open servicing market place ») connecte les investisseurs et les gestionnaires d’actifs aux meilleurs fournisseurs de données et de services ESG de manière simple, évolutive et sécurisée MANAOS assure ainsi une connexion rapide et aisée entre les systèmes d’information traditionnels des investisseurs et des sociétés de gestion d’une part, et d’un panel de fintechs et regtechs soigneusement sélectionnées d’autre part. MANAOS facilite donc la collecte des portefeuilles, la standardisation de ces données et permet une transparisation complète des portefeuilles.

Sobriété et frugalité numérique

Alors que 75% des données stockées seraient obsolètes, redondantes ou inutiles[17], une prise de conscience autour de l’incongruité de l’accroissement apparemment sans fin des données produites et stockées a eu lieu.

Face à l’infobésité ambiante, de nouvelles pratiques émergent visant à une utilisation plus sobre et raisonnée des données :

- La limitation de la durée de vie des bases de données

- L’équilibre entre stockage dans des plateformes centrales et des stockages locaux (mutualisation de données dans des hub centraux)

- La mutualisation de données achetées à l’extérieur et l’optimisation de leur utilisation…

Malgré les nombreuses études produites par les fournisseurs de cloud, il n’est pas aisé de répondre à la question de savoir si son utilisation consomme moins d’énergie et contribue moins à la dégradation des conditions environnementales, que l’utilisation de serveurs on premise[18]. D’une part, il n’est pas certain que l’optimisation de l’utilisation des serveurs compense l’effet rebond ainsi que la pratique de redondance pratiquée par les fournisseurs de cloud. D’autre part il n’est pas évident que le cycle de vie totale du serveur ait été pris en considération (coût énergétique de fabrication, provenance de l’énergie utilisée pour le fonctionnement des serveurs…).

Cette quête nouvelle de sobriété et d’hygiène numérique vient actualiser la feuille de route du DSI et du data office. (Voir la fiche : Stratégies organisationnelles et innovations technologiques)

Et l’ESG dans tout ça ?

Les évolutions réglementaires : règlement Sustainable Finance Disclosure Regulation (SFDR), loi Energie Climat (2019-1147), règlement Taxonomie (2020/852) et règlement Benchmark Climatique (2019/2089) ont créé un marché de fournisseurs de données extra-financières, aujourd’hui en phase de consolidation.

Même si les sociétés sont en phase de concentration, il n’en reste pas moins que les offres foisonnent et restent hétérogènes (suivi des controverses, production indices ESG, alignement ODD…). Il n’est pas rare de voir les sociétés utilisées entre trois et une dizaine de fournisseurs de données extra-financières en fonction des thématiques ESG. Un travail de rationalisation est à anticiper. De plus, le choix d’un fournisseur doit prendre en considération plusieurs axes d’analyse : type d’indicateurs, couverture géographique, clarté de la définition des indicateurs et des méthodologies, accessibilité des données… Enfin la politique tarifaire du fournisseur est également à analyser. Ces derniers proposent des tarifications en fonction des reportings/usages servis et/ou du périmètre et de la fréquence de données fournis.

Les fournisseurs de données ESG en fonction du périmètre de leur offre

| Fournisseurs | ESG | Scenario 2°C | Alignement avec les ODD | Études des controverses | Suivi des reco. TCFD |

|---|---|---|---|---|---|

| MSCI | |||||

| Vigeo Eiris | |||||

| Sustainalytics | |||||

| ISS – ESG | |||||

| Inrate | |||||

| Sequantis | |||||

| Carbone 4 | E | ||||

| I care & consult | E | ||||

| Trucost | E | ||||

| CDP | E | ||||

| Beyond Ratings | |||||

| Ethifinance | |||||

| Impak | |||||

| Arabesque | |||||

| Rep risk | |||||

| Bloomberg |

Source : 99 Advisory

En 2020, près de 11 000 milliards d’euros d’actifs européens (45 % du total) intègrent d’une façon ou d’une autre des critères ESG, selon l’étude publiée en novembre 2020 par l’EFAMA, l’association européenne de la gestion d’actifs.

Quelques fournisseurs de données extra- financières : cartographie des données, utilisation réglementaire et offre de services

| Fournisseurs | Données Brutes | Données calculées | Utilisation règlementaire | Offre de services |

|---|---|---|---|---|

| Trucost |

|

Intensité Carbone pondérée (somme du scope 1 et 2) en fonction du corporate |

|

Calcul des risques liées aux enjeux ESG |

| MSCI |

|

Pondération par rapport au portefeuille |

|

Mesure de la résilience d’une entreprise aux risques ESG en fonction de son secteur grâce à une notation avec une synthèse des principaux enjeux, risques ESG du secteur |

| Vigeo Eiris |

|

|

Certification ARISTA 3.0 | Élaboration d’indice éthique |

| Sustainalytics |

|

Calcul du score global par pondération |

|

Formations en Global Reporting Initiative Sustainability Market Intelligence |

| ISS ESG | Données financière | Calcul de ISS ESG | N/A | Identification risque ESG et niveau d’opportunité d’investissement |

| Inrate | Émission carbone | Données carbones | N/A | Notation ISR |

| Sequantis | Données investisseurs institutionnels, mandataires ou dépositaires | « Sequantis transition monitor » Taxonomie Européenne | Label Finance Innovation |

|

| Carbone 4 | Émission carbone |

|

Label E + C | Empreinte carbone et actions possibles |

| I care & consult | Données financière et extra-financière | Mesurer impact sur la biodiversité Corporate Biodiversity Footprint | N/A | Évaluation du niveau de risque environnemental des actifs Mesure de l’impact des investissements en matière de biodiversité. |

| CDP |

|

Données carbones Data remontée ensuite sur l’outil assurantiel |

N / A | Mesure de l’empreinte écologique et l’impact des diverses émissions. |

| Beyond Ratings | Données financière et extra-financière | Analyse des risques énergétiques et climatiques des États (obligation) | N/A | Identification et prise en compte des risques dans un contexte de transition énergétique. |

| EthiFinance | 4 thèmes (gouvernance, social, environnement, parties prenantes), 22 catégories et 194 critères. Documents publics |

|

Certification ARISTA 3.0 délivrée par l’AI CSRR | EthiFinance offre des produits et services aux investisseurs et dispose d’un pôle de conseil aux entreprises en RSE et ISR |

| Impak | Données financière et extra-financière | Impak IS2, un outil de scoring, de reporting et de suivi d’impact | Certified B corporate |

|

| Arabesque -Linedata | Données extra financière | S Ray scores | N/A | Prise de décisions éclairées en matière de fonds ESG |

| Rep Risk | Données issues de tiers indépendants | Niveau de risque RRI (RepRisk Index) | N/A | Évaluation des risques de réputation des entreprises et dans le suivi des controverses |

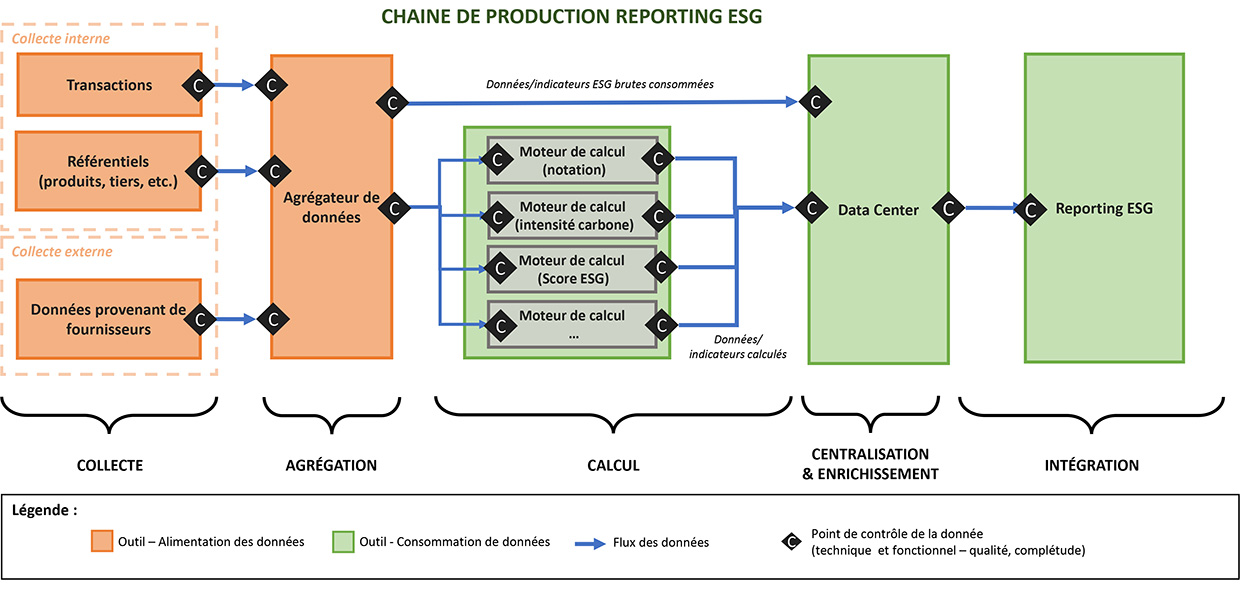

Reporting ESG

Les différentes étapes de production d’un reporting ESG, incluant les points de contrôles, peuvent être schématisées comme suit :

Le coin de la Start-up et de l’innovation

En matière d’échange de données, Dawex propose une offre pionnière. Fondé en 2015, Dawex est un acteur technologique français majeur de la Data Exchange. Son objectif est d’aider les entreprises à optimiser l’exploitation de leurs données, en leur permettant d’échanger et de monétiser – vendre ou importer – des informations avec leur écosystème (fournisseurs, revendeurs, partenaires, autorités ou même concurrents).

Dawex est la première entreprise technologique de solutions de Data Marketplaces reconnu « Technology Pioneer » par le Forum Économique Mondial. Dawex a également rejoint le Global Future Council qui réunit 30 des leaders d’opinion sur les sujets data.

Pour répondre aux besoins grandissants de valorisation de la donnée, DAWEX offre une solution qui permet à l’entreprise d’avoir la maîtrise, de contrôler les conditions et de cadrer l’échange de ses données. L’intervention se fait à quatre niveaux :

- Technologique, en garantissant la traçabilité de l’échange de données et en validant son origine. La sécurisation de la transaction s’opère quelle que soit la nature de la transaction : fichier, API, donnée en temps réel, donnée historique

- Contractuel, dans la mesure où le transfert de données hors de l’organisation qui les a collectées est contraint juridiquement. Dawex a modélisé des contrats types qui encadrent la propriété intellectuelle de la donnée, aussi bien dans un cadre d’open data que de licences privées. Ces contrats prennent en charge la territorialité, le droit d’usage, la capacité à la revendre…

- Economique, en aidant l’entreprise à vendre ses données. Dawex propose également un accompagnement pour déterminer une stratégie data

- Règlementaire, car il faut s’assurer de la conformité réglementaire de la circulation des données, notamment avec RGPD qui encadre le traitement des données à caractère personnel

Des données en provenance d’initiatives issues de différentes industries sont aujourd’hui échangées et monétisées sur la plateforme DAWEX. Par exemple :

- API-Agro : Agdatahub est une entreprise portée par le secteur agricole qui propose aux acteurs de la filière des technologies souveraines pour maîtriser les usages et garantir les consentements des agriculteurs et des éleveurs dans l’échange de leurs données

- NumAlim Data Exchange Platform : Lancé au 1er trimestre 2021, NumAlim Data Exchange Platform propose à 18 000 entreprises de l’agroalimentaire de valoriser, acquérir et enrichir tous types de données : production, consommation, traçabilité, avis et études consommateurs, ainsi qu’un vaste bouquet de services autour des données (analyses de tendance, reformulation, veille réglementaire…)

- Space Data Marketplace (en partenariat avec le CNES, France Relance / Consortium : Airbus Defence and Space, Dassault Systèmes, Thales Alenia Space, Geoflex, VisioTerra, namR, Altametris, Murmuration, Occitanie Data) : Space Data Marketplace est le guichet unique pour l’industrie spatiale et toutes les organisations de multiples secteurs qui sont de plus en plus intéressées par l’utilisation de données spatiales.

SESAMm est le leader français des solutions de Big Data et d’Intelligence Artificielle appliquées à la gestion d’actifs. L’entreprise est spécialisée dans la création d’analytics innovants et en data alternative : elle analyse en temps réel des milliards de messages, articles et posts issus de plusieurs millions de sources de données. Son équipe compte plus de 50 personnes, principalement des ingénieurs et chercheurs, et est basée à Paris, New-York, Tokyo, Tunis & Metz.

QuantCube Technology : créée en 2013, elle applique l’IA à la macro-économie. La société exploite des données alternatives et hétérogènes provenant de sources variées : réseaux sociaux, prix produits, images satellites, données d’entreprises… La maîtrise des outils de data science tels que l’apprentissage profond, le traitement automatique du langage, ou la vision par ordinateur, appliqués aux jeux de données alternatives, leur permet de produire en avance de cycle des prévisions assez précises d’indicateurs de tendances macro-économiques (et disponibles plusieurs semaines ou mois après). Ces indicateurs sont utilisés par les clients pour optimiser leurs investissements moyen/long terme ou améliorer les politiques publiques.

Conclusion

La valorisation des données passe par une trajectoire de transformation qui doit se mettre en place progressivement dans les sociétés de gestion. De nombreux pré-requis sont à considérer, en termes :

- d’architecture : infrastructure qui se « cloudifie », informations accessibles de plus en plus en temps réel…

- d’organisation : mise en place d’équipes nécessaires à l’exploitation et à la gouvernance des données (data office, par exemple)

- d’insertion dans un écosystème facilitant l’émergence de solutions innovantes et de partenariats

Avant de créer de la valeur, les données doivent être de qualité, exhaustives, exactes et sécurisées. Ce qui implique un minimum de réflexion sur les options à prendre pour leur collecte, leur traitement, leur enrichissement par des données externes par exemple et leur restitution. D’où le besoin de définir une stratégie data, qui posera à la fois les ambitions et les macro-usages mais également les leviers technologiques à considérer. L’effort d’investissement est réel et significatif si les sociétés de gestion veulent continuer à répondre aux attentes des clients dans les années à venir.

Ce qu’il faut retenir

Pour maitriser sa donnée, établir une gouvernance de celle-ci est nécessaire. La mise en place d’un Data Office qui définit et met en œuvre la gestion de la donnée est ainsi centrale. Outre le pilotage de la gouvernance des données, le Chief Data Officer a pour principales missions d’adapter l’organisation de sa société de gestion à la « dataisation ». Pour faire face à cette problématique, les grandes sociétés de gestion ont opté pour une centralisation de leurs référentiels en adoptant le cloud comme socle de leur infrastructure.

Consultez nos « recommandations » et notre page « remerciements ».